Seit Monaten sprechen alle davon: Wenn GPT-4 kommt, ändert sich alles. Wir haben für euch geprüft, was dran ist und was sich wirklich verbessert hat. So viel vorneweg: GPT-4 ist wirklich mächtig. Aber was ändert sich mit GPT-4 konkret?

GPT-4 ist multimodal

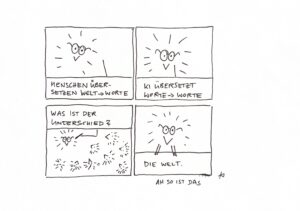

Im Gegensatz zu den Vorgänger-Modellen ist GPT-4 ein multimodales Modell. Das heißt, es kann Input verschiedener Art verarbeitet. Zum Beispiel Bilder. Man fügt ein Bild ein und bekommt Output aus dem System. Eine konkrete Anwendung für Menschen in der Kommunikationsbranche: Du zeichnest per Hand wireframes, fütterst es GPT-4 und bekommst Inhalte sowie Code aus GPT-4. Aktuell ist multimodaler Input aber erst für ForscherInnen verfügbar. Fazit: Multimodalität eröffnet neue Möglichkeiten für Marketingmaßnahmen, die visuelle Elemente und Text kombinieren. Bei Aleph Alpha (aleph-alpha.com) könnt ihr übrigens schon seit Monaten multimodal Inhalte verarbeiten. Das ist ein deutsches Unternehmen, deren Interface wir auch gerne nutzen.

GPT-4 beherrscht Programmiersprachen

Programmierer als Gate-Keeper fürs Marketing, diese Rolle wird sich verschieben. Denn mit den Codex-Sprachmodellen hatte man schon die Möglichkeit auf Basis eines Inputs in Form eines natürlichen Texts Code erzeugen zu lassen. Das kann nun auch GPT-4. Damit können Marketer sagen: „Schau, ich habe meine Idee schon einmal mit GPT-4 in einer Programmiersprache nach Wahl als Entwurf vorbereitet. Was hältst du davon?“ Für mich ändert das einiges!

GPT-4 ist kompetenter

GPT-4 hat den Sommelier-Test bestanden. Ich wusste ja nicht einmal, dass es hier ein offizielles Prüfungsschema gibt… Aber ja, GPT-4 ist kompetent in vielen Wissens- und Fachdomänen. Hier ein Vergleich mit der Leistung von GPT-3.5:

GPT-4 beherrscht längere Inhalte

GPT-4 kann sehr viel längere Texte verarbeiten, sowohl als Prompt, als auch als Output. In Zahlen: Bei GPT-3 war bisher bei 4.000 Tokens Schluss, das entspricht Pi mal Daumen 2.500 Wörtern. GPT-4 schafft 32.000 Tokens. Das heißt, ihr könnt schon mit Hilfe des Prompts euren Output wesentlich besser auf euch zuschneiden, wenn ihr mehr Beispiel-Texte einfügt. Wenn ihr einen Roman schreiben wollt, dann braucht ihr für 100 Seiten Text nicht recht viel mehr als drei kohärente Prompts… Längere Textverarbeitung ist natürlich auch gut für das OpenAI Geschäftsmodell, aber: Fair enough, denn Preis-Leistung stimmt hier noch.

GPT-4 lässt sich mit Prompts tunen

Prompts und Prompt-Techniken, die für Sprachmodelle entwickelt und getestet wurden, kitzeln auch aus GPT-4 noch mehr heraus. Few-Shot und Chain-of-Thought Prompting sind immer noch entscheidend. Das heißt: Am Ende hast es immer noch Du in der Hand, ob Dein Output gut ist – oder nicht. Du kannst hier noch einmal lesen, warum genau Du Dich mit Prompt Engineering beschäftigen sollst, zumindest unserer Ansicht nach: Warum Designer jetzt Prompt Engineering lernen müssen

TL;DR

GPT-4 von OpenAI bietet zahlreiche Möglichkeiten für Marketingprofis, ihre Strategien und Prozesse zu optimieren. Die Verbesserungen gegenüber GPT-3 sind signifikant und eröffnen neue Anwendungsmöglichkeiten, wie die Multimodalität und die Fähigkeit, längere Texte und Konversationen zu verarbeiten. Unternehmen, die GPT-4 effektiv einsetzen, können von einer effizienteren Content-Generierung, besseren Personalisierung und einer höheren Reichweite profitieren. Durch den Einsatz von GPT-4 können Marketingteams ihre Ressourcen strategischer nutzen und innovative Kampagnen entwickeln, die auf die Bedürfnisse ihrer Kunden zugeschnitten sind. Auch in näherer Zukunft kommt es auf die Prompts an, um guten Output zu bekommen. Dieser letzte Absatz wurde von GPT-4 verfasst, der Rest von Vroni.

Hier noch der Prompt zum Beitragsbild: stable diffusion 1.5: strybk-tree-kids-story-book-style-muted-colors-watercolor-style