Inhaltsverzeichnis

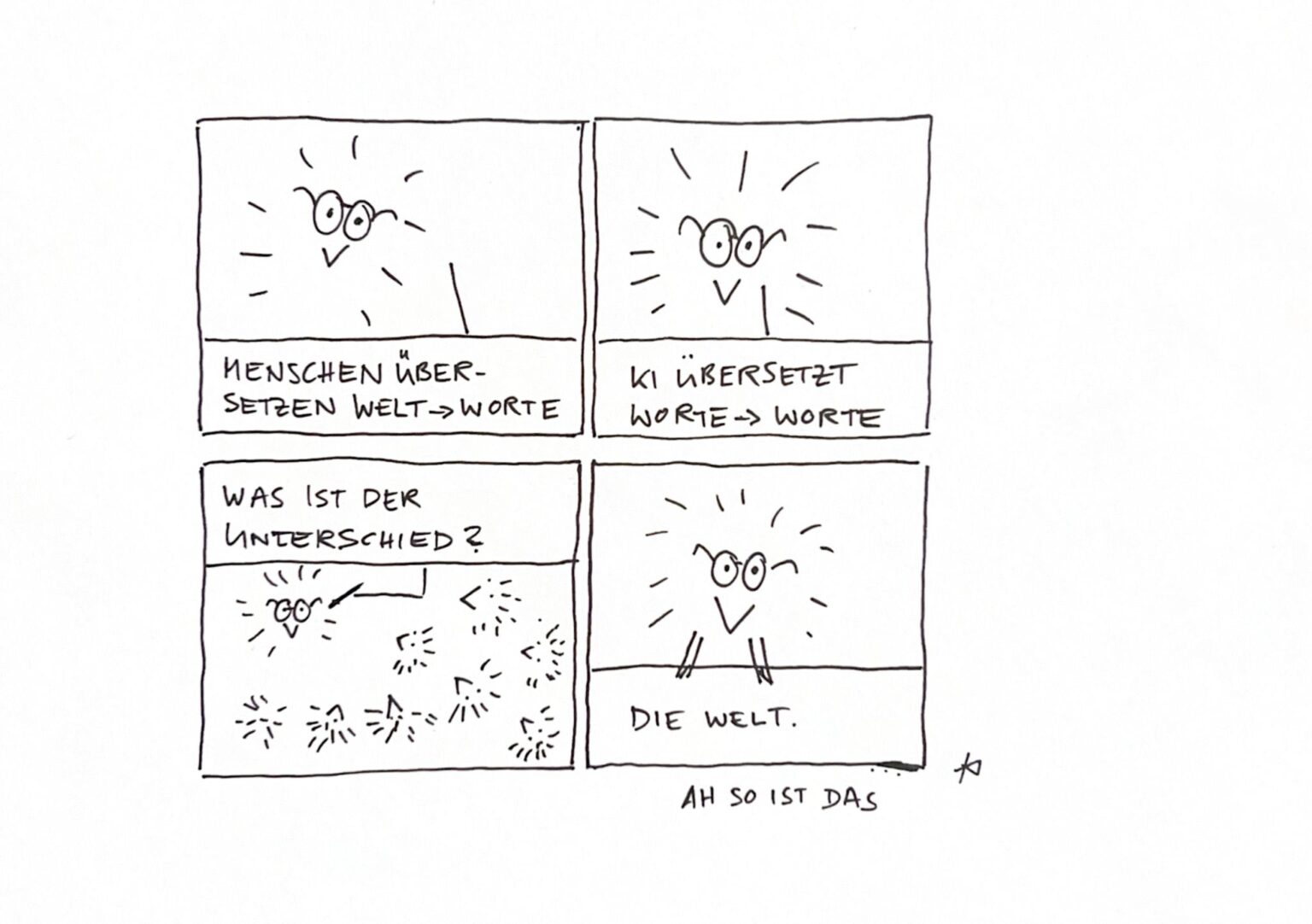

Das Wörterbuch-Problem

Der Kognitionswissenschaftler Stevan Harnad hat das Problem 1990 so formuliert: Stell dir vor, du versuchst Chinesisch zu lernen, aber du hast nur ein chinesisch-chinesisches Wörterbuch. Du schlägst ein Zeichen nach. Die Erklärung besteht aus anderen Zeichen. Du schlägst diese nach. Wieder neue Zeichen. Du könntest ewig weitermachen und würdest trotzdem nie verstehen, was irgendeines dieser Zeichen bedeutet.

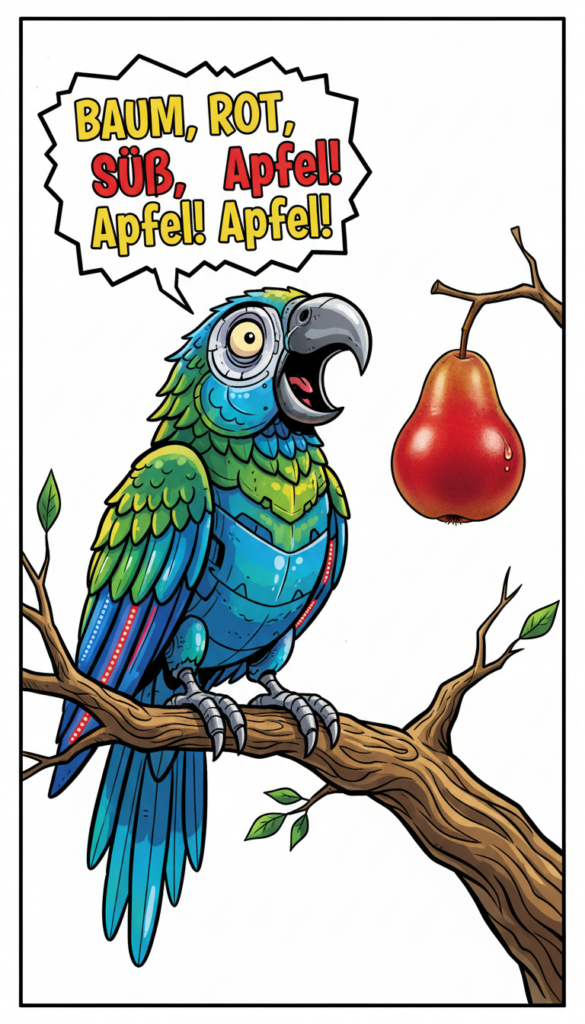

Genau das ist die Situation von Sprachmodellen. Sie wurden mit Milliarden von Texten trainiert, in denen Worte auf andere Worte verweisen. „Apfel“ kommt oft in der Nähe von „rot“, „süß“, „Baum“ vor. Das Modell lernt diese statistischen Muster perfekt. Aber es hat nie einen Apfel gesehen, geschmeckt oder gepflückt.

Die Linguistin Emily Bender hat dafür 2021 den Begriff „stochastischer Papagei“ geprägt: ein System, das Sprachmuster aneinanderreiht, ohne Bezug zur Bedeutung. Der Begriff ist polemisch, und ich halte ihn für zu einfach. Aber er trifft einen Kern.

Warum das kein akademisches Problem ist

Die praktischen Konsequenzen begegnen uns täglich.

Halluzinationen sind das offensichtlichste Symptom. Wenn ChatGPT eine Quelle erfindet, die nicht existiert, dann liegt das nicht an einem Bug. Das Modell hat gelernt, dass auf bestimmte Fragen bestimmte Muster folgen – „laut einer Studie von…“. Es füllt die Lücke mit statistisch plausiblem Text. Ob die Studie existiert, kann es nicht wissen. Es hat keinen Zugang zur Welt, in der Studien existieren oder nicht.

Leere Formulierungen sind subtiler. KI-Texte klingen oft seltsam generisch, nicht weil das Modell schlecht promptet wurde, sondern weil es keinen Unterschied kennt zwischen einer Aussage, die etwas bedeutet, und einer, die nur so klingt. „In der heutigen schnelllebigen Welt“ ist statistisch häufig. Also kommt es oft vor. Dass der Satz nichts sagt, kann das Modell nicht erkennen.

Keine Relevanz-Unterscheidung ist vielleicht das größte Problem für die Praxis. Wenn du ChatGPT bittest, dir zehn Kampagnen-Ideen für dein Produkt zu generieren, liefert es zehn Ideen. Ob davon drei brillant sind und sieben Unsinn, das kann das Modell nicht beurteilen. Es kennt dein Produkt nicht wirklich. Es kennt deine Kunden nicht. Es kennt die Welt nicht, in der deine Kampagne funktionieren müsste.

Die Gegenposition, und warum sie teilweise stimmt

Ich will hier nicht den Fehler machen, KI als „nur“ ein statistisches System abzutun. Die Debatte hat mehr Schichten.

Aktuelle Forschung zeigt, dass große Sprachmodelle intern durchaus etwas wie „Weltmodelle“ entwickeln, Repräsentationen, die über bloße Wortstatistik hinausgehen. In bestimmten Tests zeigen sie Verständnis für räumliche Beziehungen, logische Zusammenhänge, sogar physikalische Intuition.

Und bei Bildgenerierung wie Diffusion Models entsteht tatsächlich Neues. Das sind keine Collagen aus Trainingsbildern. Die Modelle haben offenbar etwas über die Struktur von Bildern gelernt, das generalisiert.

Also: Ist das Symbol Grounding Problem gelöst?

Nein. Aber es ist komplizierter als „KI versteht nichts“.

Warum tausend Kampagnen nichts bringen

Ich erlebe regelmäßig in Seminaren: Teilnehmer entdecken, wie schnell ChatGPT Ideen generiert. Sie lassen sich hundert Slogans, fünfzig Zielgruppen-Personas, dreißig Content-Pläne erstellen. Und dann passiert, nichts. Die Ideen liegen rum. Keine wird umgesetzt.

Das ist kein Motivationsproblem. Das ist ein Grounding-Problem.

Die KI hat diese Kampagnen aus Worten über Marketing-Kampagnen zusammengesetzt. Die Teilnehmer spüren intuitiv, dass die Vorschläge nicht „geerdet“ sind, nicht in ihrer Branche, nicht bei ihren Kunden, nicht in ihrer Realität. Die Ideen klingen plausibel, aber sie fühlen sich leer an.

Die Lösung ist nicht, bessere Prompts zu schreiben. Die Lösung ist, die Verbindung zur Welt selbst herzustellen. Die KI liefert Rohmaterial. Die Übersetzung von Worten in Welt, das bleibt menschliche Arbeit.

Welt bleibt Welt

KI ist ein beeindruckendes Werkzeug. Sie wird besser werden. Multimodale Modelle, die Bilder und Text verarbeiten, könnten das Grounding-Problem teilweise entschärfen. Vielleicht werden zukünftige Systeme etwas entwickeln, das wir „Verständnis“ nennen würden.

Aber heute, im Jahr 2026, gilt: Wenn du mit KI arbeitest, arbeitest du mit einem System, das Worte in Worte übersetzt. Es kennt nicht deine Kunden. Es kennt nicht deinen Markt. Es kennt nicht die Welt, in der deine Arbeit bestehen muss.

Das macht KI nicht nutzlos. Es macht sie zu dem, was sie ist: ein Werkzeug, das von Menschen geführt werden muss, die die Welt kennen.

Die wirklich wichtige Kompetenz ist nicht, KI besser prompten zu können. Es ist, die Brücke zwischen den Worten und der Welt selbst zu bauen.

Du willst auch so coole Sachen mit KI machen?

Klar, neue Tools kommen ständig raus – und irgendwann verliert man den Überblick. Wir helfen dir dabei, dass du weißt, was du machst.

Unsere Weiterbildungen:

AI Content Creator (11h Live): Lerne, wie du KI für Texte, Bilder und Social Media nutzt. Vormittags, entspannt, und du kannst alles direkt ausprobieren.

AI Content Manager mit IHK-Zertifikat (20h Live): Mehr Tiefe gefällig? Hier gehts um richtige Content-Strategien und Kampagnen – plus ein IHK-Zertifikat!

AI Art Director (20h Live): Von Bild-KI bis nodebasierte Workflows: In dieser Weiterbildung baust du dir die Skills auf, die für Art Direction mit KI fehlen, kompakt und praxisnah

Alle Sessions sind live, kompakt am Vormittag und praxisnah, perfekt, um sie in deinen Alltag zu integrieren.

Was uns ausmacht: Wir machen KI seit 2022 und wissen, was funktioniert und was nur heiße Luft ist. Du lernst das, was du wirklich brauchst.

Für Teams: Dein ganzes Team soll mitkommen? Können wir machen – einfach melden.