Text-to-Video-KI-Tools, wie Runway, Pikalabs und Stable Video Diffusion revolutionieren die Art und Weise, wie wir Inhalte erstellen. Dieser Artikel vergleicht diese drei führenden Tools und bietet einen Ausblick auf den optimalen Workflow und die Zukunft der Videogeneratoren.

Video-KI-Tools im Überblick

Runway

Runway AI Inc. ist eines der führenden Unternehmen, wenn es um Video-KI-Tools geht. Neben dem Kerngebiet der Videogenerierierung bietet Runway zusätzlich spannende Tools für alle Videocutter:

- Inhaltsentfernung: Entfernt Personen oder Objekte aus jedem Video.

- Super Slow-Mo: Verwandelt jedes Video in Super-Zeitlupe.

- Animierte Sequenzen: Verwandelt Bildsequenzen in animierte Videos.

- Hintergrundentfernung: Entfernt mit einem Klick den Hintergrund aus Videos.

Aber dafür ist Runway nicht bekannt. Als einer der ersten Anbieter konnte man mit Runay Gen-1 bereits brauchbares Footage mit txt2video generieren. Mit dem neuesten Model Gen-2 gehen Sie einen guten Schritt weiter und bieten jetzt auch Möglichkeiten zur Kontrolle der Bewegungsrichtung, Kamerawinkel uvm.

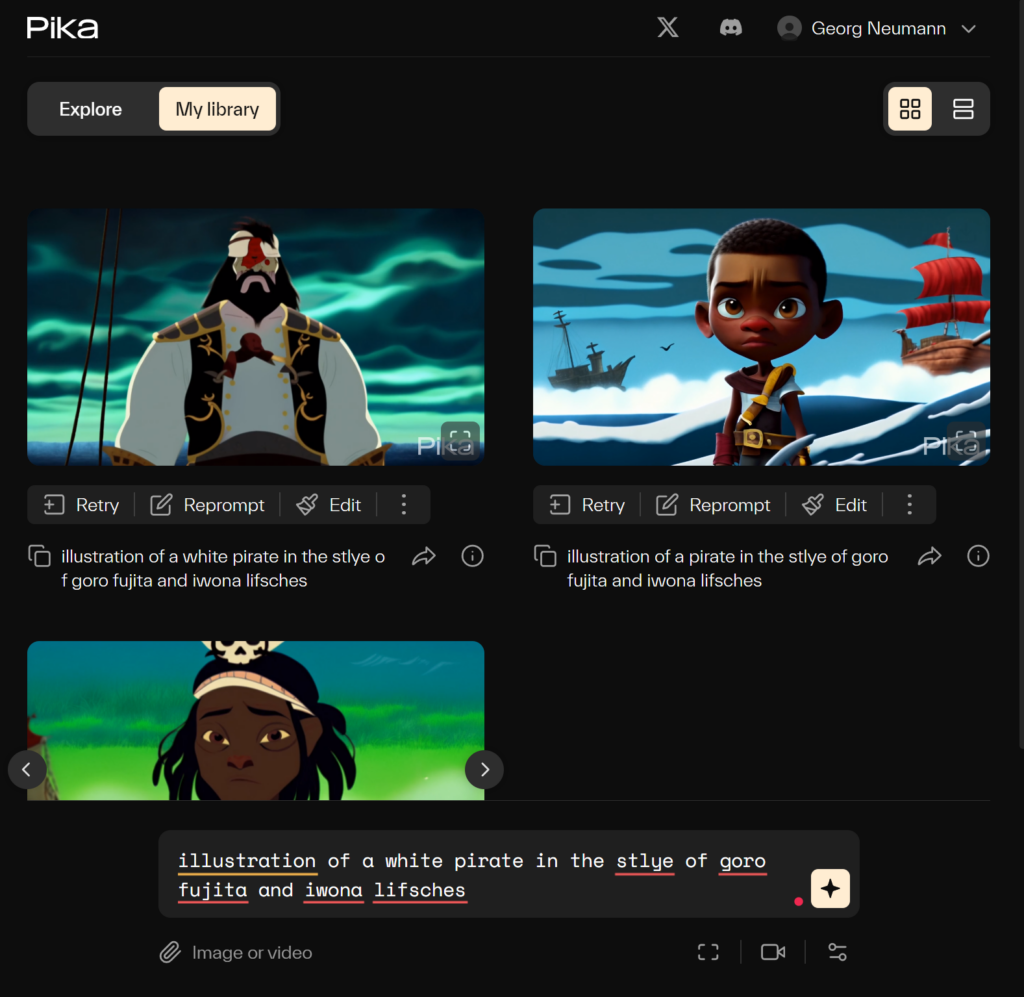

Pika Labs

Pika ist eine NonProfit Organisation, die die Grenzen von Video-KI austesten will. Bis vor kurzem war Pika Labs noch in einer Testphase und nur über Discord nutzbar, aber jetzt sind wir diese Limitierungen los. Auf pika.art könnt ihr euch kostenlos registrieren und loslegen. Hier die Pika Labs Features im Überblick:

- txt2video: Mit reinem Prompt ein Video generieren lassen

- img2video: Auf Basis eines Bilds ein Video generieren lassen (mit Möglichkeit einen Prompt zu nutzen)

- Parameter: Seitenverhältnis, Kamerasteuerung, negative prompt, Seed uvm

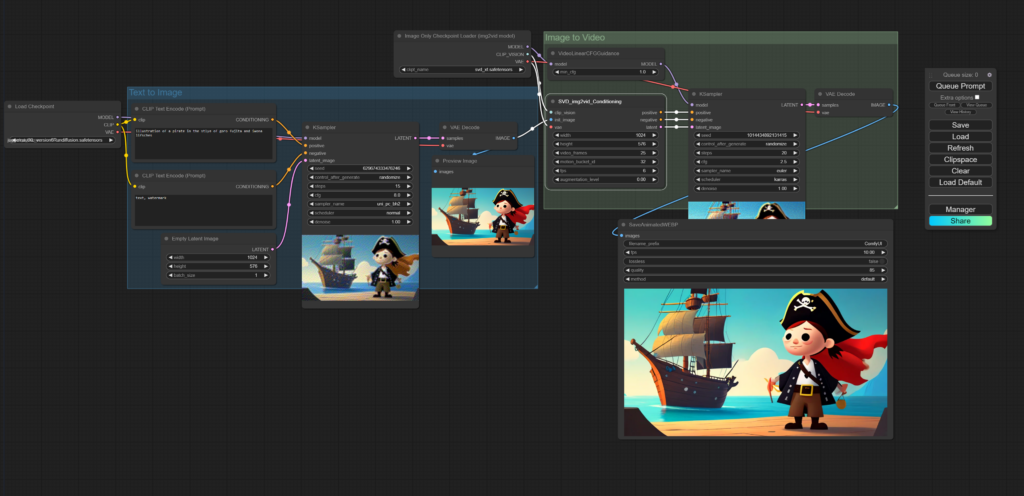

Stable Video Diffusion

Wie immer bei Stable Diffusion: Wir reden nicht von einem Anbieter, sondern von einer Technik. Stability AI hat vor kurzem Stable Video Diffusion (SVD) veröffentlicht. Ein Bild-KI Foundationmodell, das mit 6 Frames pro Sekunde Bildsequenzen generieren kann. Hier im Überblick:

- txt2video: Mit reinem Prompt ein Video generieren lassen

- img2video: Auf Basis eines Bilds ein Video generieren lassen (mit Möglichkeit einen Prompt zu nutzen)

- Parameter: Motion Bucket ID (Stärke der Bewegung), Augmenatation Level (subtile Änderungen der Bewegung), Bildverhältnis

- Auflösung: Nicht höher als 1024×576 Pixel

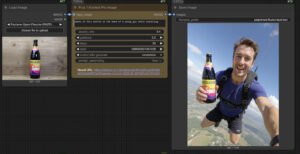

Stable Video Diffusion, Pika Labs und Runway Gen-2 im direkten img2video Vergleich:

Um mir selbst ein Bild zu machen, habe ich alle das gleiche generieren lassen. Ausgangslage war das Beitragsbild von oben.

Stable Video Diffusion

Man merkt es Stable Video Diffusion schnell an: Viel geht hier noch nicht. Die 6 FPS sind aktuell noch die größte Limitierung und wirklich Einfluss kann man auf das Ergebnis auch nicht nehmen.

Pika Labs

Leichte Bewegung im Wasser und unser Pirat lernt sprechen. Schonmal sehr gut!

Runway Gen-2

Runway Gen-2 nimmt sich die Freiheit das Ausgangsbild auch visuell weiter aufzuwerten. Kann man mögen, muss man nicht. Aber eindeutig der Gewinner beim Grad und Art der Bewegung.

Workflow oder der Kampf gegen den Zufall

Seien wir mal ehrlich: Wenn ihr gute Ergebnisse von Video-KI Tools seht, dann sind das die Sahnestücke, denn wer unsere Kurse besucht hat lernt ganz schnell:

- Die KI versteht nichts

- Ergebnisse sind zufällig und gleichzeitig wahrscheinlich

Bedeutet im Klartext: Ihr werdet auch viel Müll erzeugt bekommen. Der beste Workflow ist also unabhängig von der Wahl des Tools:

- Zielsetzung: Definieren vorher was du erreichen möchtest.

- Tool-Auswahl: Probier alle Tools und Möglichkeiten aus, bevor du dich an ein konkretes Projekt machst, so kannst du besser auswählen, welche Technik/Anbieter für dein Unterfangen passt.

- Inhaltsvorbereitung: Bereite die Szenen möglichst gut vor mit Prompts für txt2video oder mit gutem Ausgangsmaterial bei img2video.

- Generieren, generieren, generieren: Um brauchbare Ergebnisse zu bekommen, ist es aktuell oft nötig zig Varianten der gleichen Szene zu erstellen, um zu einem brauchbaren Ergebnis zu kommen.

- Anpassung: Falls ein Prompt oder eine Szene partout nicht klappen will, kann man diese auch konzeptionell überdenken und ggf. vereinfachen

- Die Kombination machts: Verrennt euch nicht im Hasenbau. Ihr müsst nicht plötzlich alle Projekte mit KI umsetzen, nur weil man das jetzt kann. Kombiniert verschiedene Techniken, um zum perfekten Ergebnis zu gelangen.

Zukunft der Video-KI

Die Entwicklungen im Bereich der Video-KI sind atemberaubend. Was wir heute sehen, ist nur die Spitze des Eisbergs. In naher Zukunft wird die Technologie so weit fortgeschritten sein, dass das Erstellen von individuellem Stockfootage oder das Anpassen von Szenen für spezifische Anforderungen mit wenigen Klicks möglich sein wird. Die stetige Verbesserung der Qualität und Geschwindigkeit dieser Tools wird die Landschaft der Videoproduktion und des Marketings grundlegend verändern.

Fazit

Es ist entscheidend, jetzt in diese Technologien einzusteigen. Verstehen und nutzen zu lernen, wie KI-Videotools funktionieren, wird dir einen erheblichen Vorteil in der schnelllebigen Welt des digitalen Marketings verschaffen. Bei unserem KI Marketing Bootcamp bieten wir dir die nötigen Ressourcen und das Know-how, um diese spannende Reise zu beginnen und an der Spitze der Innovation zu bleiben.