DeepSeek – momentan überall zu hören. Egal ob in Fachartikeln, Diskussionen oder KI-Communities: Dieses Modell sorgt gerade für ordentlich Gesprächsstoff. Und das zu Recht, denn mit DeepSeek R1 steht ein Modell im Rampenlicht, das nicht nur durch beeindruckende Technik glänzt, sondern auch kritische Fragen aufwirft. Was steckt hinter diesem „Gamechanger“ der Künstlichen Intelligenz? Ist es wirklich so bahnbrechend, wie viele behaupten, oder gibt es Haken, die man nicht übersehen darf?

Lasst uns zusammen einen genauen Blick auf DeepSeek R1 werfen – auf seine Stärken, seine Schwächen und darauf, was dieses Modell für die Zukunft der KI bedeuten könnte.

Kurz zur Unterscheidung: Es gibt auch das v3-Modell. Das entspricht, grob gesagt, der Leistungsfähigkeit von GPT-4. Das R1-Modell hingegen geht eher in Richtung der o1, bzw. o3 Modelle von OpenAI. Hier geht’s zu den jeweiligen Reports:

v3: https://arxiv.org/pdf/2412.19437

R1: https://arxiv.org/pdf/2501.12948

Inhaltsverzeichnis

Was macht DeepSeek R1 so besonders?

DeepSeek R1 wird gerade ziemlich gefeiert, und das zu Recht. Entwickelt wurde das Modell von einem chinesischen Hedgefonds namens High-Flyer, der ordentlich in Know-how und Technik investiert hat. Dabei wird oft gesagt, dass die Entwicklung „nur“ 5 bis 6 Millionen Dollar gekostet haben soll. Diese Zahl bezieht sich allerdings nur auf die Cloud-Kosten. Was oft unter den Tisch fällt: Die massive Hardware, die dafür nötig war – wie zum Beispiel 50.000 NVIDIA H100 GPUs im Wert von 1,5 Milliarden Dollar.

Aber was macht DeepSeek R1 technisch so spannend? Ein Highlight ist der sogenannte „Chain of Thought“-Ansatz. Das bedeutet, dass das Modell seine Überlegungen Schritt für Schritt erklärt. Das ist nicht nur praktisch, um Fehler zu finden, sondern macht die Antworten auch nachvollziehbarer.

Ein weiteres Plus: Das Modell lernt durch Reinforcement Learning (RL). Anstatt nur auf festgelegte Daten zurückzugreifen, probiert es selbst aus und verbessert sich mit der Zeit. Dabei kommt eine spezielle Technik namens „Group Relative Policy Optimization“ (GRPO) zum Einsatz, die das Training effizienter macht.

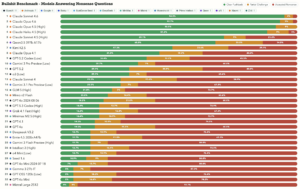

Dann ist da noch das Thema Modell-Destillation: Das ursprüngliche, riesige Modell mit 671 Milliarden Parametern dient quasi als Lehrer für kleinere Modelle. Diese kompakten Varianten liefern ähnliche Ergebnisse, sind aber deutlich weniger anspruchsvoll, was Speicher und Rechenleistung angeht. Besonders spannend ist, dass einige dieser kleineren Modelle in Tests sogar besser abgeschnitten haben als etablierte Modelle wie GPT-4.

Wenn du tiefer in die technischen Details von DeepSeek R1 eintauchen möchtest, findest du alle Informationen direkt im offiziellen DeepSeek-R1-Paper.“

Der Weg zu DeepSeek R1: Die Rolle von R1-Zero

Bevor DeepSeek R1 entwickelt wurde, gab es ein Modell namens DeepSeek-R1-Zero. Dieses Modell hat die Basis gelegt und wurde direkt durch Reinforcement Learning trainiert – ohne vorher überwachte Daten einzusetzen. Das ist ziemlich beeindruckend, weil es zeigt, dass Modelle auch ohne „Anleitung“ auf einem hohen Niveau starten können.

DeepSeek-R1-Zero konnte eigenständig seine „Denkzeit“ für schwierige Aufgaben verlängern und sogar seine Herangehensweise überdenken, wenn sie nicht funktionierte. Das ist ein bisschen so, als würde das Modell selbst merken, dass es sich verrannt hat, und von vorne anfangen. Aber: Es gab auch Probleme, zum Beispiel in der Lesbarkeit der Antworten oder bei der Mischung von verschiedenen Sprachen.

Die Entwicklung von DeepSeek R1: Vier Phasen zum Erfolg

Um diese Schwächen auszubessern, wurde DeepSeek R1 in vier Phasen trainiert:

Phase 1: Cold Start

Hier wurden die Daten von R1-Zero genutzt, die als besonders qualitativ und lesbar galten. Ziel war es, die Lesbarkeit weiter zu verbessern.

Phase 2: Reasoning Reinforcement Learning

Der Fokus lag darauf, die Argumentationsfähigkeiten des Modells in Bereichen wie Mathematik, Programmierung und Wissenschaft zu verbessern. Gleichzeitig wurde darauf geachtet, dass keine Sprachmischungen auftreten, indem sprachliche Konsistenz belohnt wurde.

Phase 3: Rejection Sampling und Supervised Fine-Tuning

Das Modell generierte viele Antworten, von denen nur die besten ausgewählt wurden. Diese hochwertigen Daten dienten dann als Grundlage für das weitere Training.

Phase 4: Diverse Reinforcement Learning

In der letzten Phase wurden unterschiedlichste Aufgaben integriert. Regelbasierte Belohnungen kamen zum Einsatz, und ein großes Sprachmodell gab Feedback, um die Ergebnisse an menschliche Vorlieben anzupassen.

Das Ergebnis? Ein Modell, das in Tests wie AIME oder MATH-500 auf Augenhöhe mit den Besten der Branche spielt.

Wenn du mehr über die praktische Anwendung von KI lernen möchtest, schau dir unsere fünf Deep Dives an – sie sind praxisnah, verständlich und direkt umsetzbar.

Die Schattenseiten von DeepSeek R1

Trotz aller Fortschritte hat auch DeepSeek R1 seine Schwächen. Besonders das Thema Datenschutz sorgt für Diskussionen. Die Server von DeepSeek stehen in China, was bedeutet, dass Nutzerdaten potenziell von chinesischen Behörden eingesehen werden könnten. Das Modell speichert nicht nur eure Eingaben und hochgeladenen Dateien, sondern erfasst sogar Tastatureingaben – ein Aspekt, der mit der europäischen DSGVO schwer vereinbar sein dürfte.

Ein weiteres Problem ist der Bias in den Antworten. Während R1 in Mathematik und Wissenschaft glänzt, zeigt es bei anderen Sprachen gelegentlich Schwächen, wie eine Mischung aus verschiedenen Sprachstilen. Auch Multi-Turn-Dialoge und spezifische Funktionen wie das präzise Ausführen von Aufgaben könnten noch verbessert werden.

Warum DeepSeek R1 trotzdem wichtig ist

Bei all der Kritik darf man nicht vergessen, was für ein enormes Potenzial in diesem Modell steckt. Die Kombination aus Reinforcement Learning und Modell-Destillation hat die Entwicklung von KI auf ein neues Niveau gehoben – ohne dabei auf massive Ressourcen angewiesen zu sein.

Das Spannende ist, dass DeepSeek R1 den Weg für eine neue Generation von KI-Modellen ebnet, die leistungsstark und gleichzeitig zugänglich sind. Mit dieser Technik könnten bald hochentwickelte Modelle auch auf kleineren Geräten wie Smartphones laufen, was die Nutzungsmöglichkeiten erheblich erweitert.

Fazit: Fortschritt mit Verantwortung

DeepSeek R1 ist ein spannender Meilenstein in der KI-Entwicklung. Es zeigt, wie weit die Technik kommen kann, wenn ambitionierte Ideen auf die richtige Umsetzung treffen. Gleichzeitig darf man die Herausforderungen, insbesondere beim Datenschutz und der Transparenz, nicht ignorieren.

Die entscheidende Frage ist, wie wir diese Entwicklungen nutzen. Anstatt uns von Risiken abschrecken zu lassen, sollten wir darauf achten, Innovation mit Verantwortung zu verbinden. DeepSeek R1 bietet uns die Chance, die Zukunft der KI aktiv mitzugestalten – aber es liegt an uns, sie sinnvoll einzusetzen.

Nutze die Möglichkeiten der KI – Entwickle mit uns effektive KI-Marketingstrategien!

Bist du bereit, die vielfältigen Möglichkeiten der Künstlichen Intelligenz zu entdecken und innovative Marketingkampagnen zu entwickeln? Dann bist du bei uns genau richtig! In unserem KI Marketing Bootcamp zeigen wir dir, wie du KI trotz der aktuellen Stagnation effektiv nutzt, um deine Marketingziele zu erreichen.

Was erwartet dich?

- Praxisorientierte Anleitungen: Lerne, wie man KI in Marketingstrategien einbindet und das Beste aus ihr herausholt.

- Kreative Strategie: Entdecke, wie Technologie und Storytelling für effektive Kampagnen zusammenwirken.

- Individuelle Begleitung: Profitiere von kleinen Gruppen, direkter Unterstützung und persönlicher Betreuung.

Deine Vorteile:

- Learning by Doing: Entwickle eigene Ideen und Kampagnenelemente, die auf deine spezifischen Herausforderungen und Ziele abgestimmt sind.

- Erfahrungswissen: Nutze echte Praxisbeispiele und Erfolgsgeschichten, um deine eigenen Strategien zu verbessern.

- Flexibel: 100 % online – bequem und ortsunabhängig.

Für Unternehmen:

Wir bieten maßgeschneiderte Workshops, um deine Marketingabteilung mit den neuesten KI-Technologien zu stärken.

Dein Expertenteam:

Vroni Hackl und Georg Neumann – zwei Experten in KI und Marketing, die dir helfen, das Beste aus deinen KI-Marketingstrategien herauszuholen.