Nach dem Stolperstart: SD3.5 will alles besser machen

Als Stability AI im Juni 2024 Stable Diffusion 3 Medium vorstellte, war die Ernüchterung groß. Wir haben darüber berichtet. Das Modell blieb deutlich hinter den Erwartungen zurück – besonders im direkten Vergleich mit der Konkurrenz SDXL aus dem eigenen Haus und Midjourney. Nun wagt das Unternehmen mit Version 3.5 einen neuen Anlauf und präsentiert gleich drei verschiedene Modellvarianten.

Die Entwickler haben offenbar aus der Kritik gelernt. Während SD3 Medium noch mit grundlegenden Problemen bei der Bildkomposition kämpfte, verspricht die neue Version 3.5 deutliche Verbesserungen – vor allem bei der Prompt-Genauigkeit und Bildqualität. Mit dem Large-Modell, seiner schnelleren Turbo-Variante und einer überarbeiteten Medium-Version will Stability AI nun verschiedene Anwendungsszenarien optimal bedienen.

Ob das Unternehmen diesmal die hohen Erwartungen erfüllen kann? Schauen wir uns genauer an, was die neue Generation der Open-Source-Bildgenerierung zu bieten hat.

Inhaltsverzeichnis

Die drei Modelle im Überblick

Mit Stable Diffusion 3.5 geht Stability AI einen neuen Weg und bietet erstmals verschiedene Modellvarianten an, die sich gezielt an unterschiedliche Anwendungsszenarien richten. Die Strategie erinnert an OpenAIs Ansatz bei GPT-4 – für jeden Anwendungsfall das passende Modell.

Stable Diffusion 3.5 Large

Das neue Flaggschiff kommt mit beeindruckenden 8 Milliarden Parametern daher und zielt direkt auf maximale Bildqualität ab. Bemerkenswert ist die native Ausgabeauflösung von 1024×1024 Pixeln, die ohne zusätzliche Upscaling-Schritte erreicht wird. Das Modell versteht komplexe Prompts deutlich besser und soll besonders bei der Darstellung von Menschen und Gesichtern neue Maßstäbe setzen.

Stable Diffusion 3.5 Large Turbo

Für alle, denen Geschwindigkeit wichtiger ist als die letzte Nuance in der Bildqualität, bietet Stability AI eine destillierte Version des Large-Modells an. Die Turbo-Variante generiert Bilder in nur vier Durchläufen, während das normale Large-Modell 20 bis 30 Schritte benötigt. Diese Optimierung ermöglicht eine deutlich schnellere Bildgenerierung bei immer noch überzeugender Qualität.

Stable Diffusion 3.5 Medium

Die kompakteste Version arbeitet mit 2,5 Milliarden Parametern und ist speziell für den Einsatz auf Consumer-Hardware optimiert. Trotz der geringeren Modellgröße verspricht Stability AI eine deutlich bessere Performance als beim Vorgänger SD3 Medium. Das Modell eignet sich besonders für schnelle Iterationen und den Einsatz auf lokalen Systemen.

Alle drei Varianten profitieren von einem grundlegend überarbeiteten Training, das nicht nur die reine Bildqualität verbessert, sondern auch die Konsistenz zwischen Text-Prompt und generiertem Bild deutlich erhöht. Besonders interessant für Marketing-Teams: Die Modelle sollen auch ohne komplexe Prompt-Engineering-Kenntnisse gute Ergebnisse liefern.

Was ist neu bei Stable Diffusion 3.5?

Die größte Neuerung bei Stable Diffusion 3.5 ist der fundamentale Ansatz: Stability AI hat das Modell von Grund auf neu entwickelt, statt nur bestehende Architekturen zu optimieren. Das macht sich in mehreren Bereichen bemerkbar.

Verbesserte Prompt-Verarbeitung

Anders als der Vorgänger versteht Version 3.5 nun auch komplexere Beschreibungen zuverlässig. Während SD3 Medium noch häufig wichtige Details ignorierte oder falsch interpretierte, setzt die neue Generation Prompts präziser um. Besonders beeindruckend: Auch bei der Darstellung mehrerer Personen oder Objekte bleiben die gewünschten Eigenschaften und Beziehungen zueinander erhalten.

Qualitätssprung bei Menschen

Eine der größten Schwächen von SD3 Medium war die Darstellung von Menschen – insbesondere bei Händen und Gesichtern (Meme: Woman lying on grass). Die neue Version macht hier einen deutlichen Sprung nach vorne. Die generierten Personen sollen natürlicher, anatomisch korrekter und vor allem konsistenter über mehrere Generierungen hinweg wirken.

Technische Verbesserungen

Das neue Large-Modell nutzt die transformerbasierten CLIP L + G sowie einen T5 XXL Text-Encoder, um Prompts in semantisch bedeutungsvolle Repräsentationen zu übersetzen. Diese Encoder-Architektur ermöglicht ein besseres „Verständnis“ der Eingabetexte. Stability AI hat zudem Query-Key Normalization in die Transformer-Blöcke integriert, was das Training stabilisiert und weitere Entwicklungen vereinfacht. Mit seinen 8 Milliarden Parametern kann das Large-Modell deutlich mehr Nuancen und Details aus den Trainingsdaten erfassen1

.

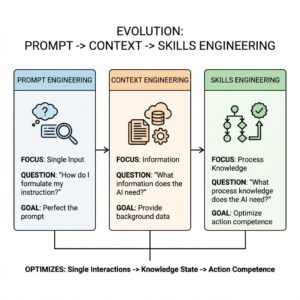

Vereinfachtes Prompt-Engineering

Stability AI verspricht, dass auch einfache, natürlichsprachliche Prompts zu guten Ergebnissen führen. Das könnte besonders für Marketing-Teams interessant sein, die schnell verschiedene Bildideen testen wollen, ohne sich tief in die Kunst des Prompt-Engineerings einarbeiten zu müssen.

Diese Verbesserungen klingen vielversprechend – vor allem nach den Schwächen des Vorgängers. Ob sie in der Praxis halten, was sie versprechen, wird sich in den kommenden Wochen zeigen, wenn mehr Kreative mit den neuen Modellen experimentieren.

Lizenzmodell & Verfügbarkeit

Stability AI bleibt seiner Open-Source-Philosophie treu, geht aber mit SD 3.5 neue Wege in der kommerziellen Nutzung. Das Lizenzmodell ist dabei überraschend großzügig gestaltet.

Kostenlose Nutzung

Für private Anwender und nicht-kommerzielle Projekte sind alle drei Modellvarianten komplett kostenlos nutzbar. Auch kleine Unternehmen mit einem Jahresumsatz unter einer Million Dollar können die Modelle ohne zusätzliche Kosten einsetzen. Das ist besonders für Freelancer und Start-ups im Kreativbereich interessant.

Kommerzielle Nutzung

Für größere Unternehmen gilt eine gestaffelte kommerzielle Lizenz. Die genauen Konditionen werden noch bekanntgegeben. Stability AI betont aber, dass die Preisgestaltung fair und transparent sein soll. Im Vergleich zu geschlossenen Systemen wie Midjourney oder DALL-E 3 bietet SD 3.5 dabei einen entscheidenden Vorteil: Die Modelle können auf eigener Hardware betrieben werden.

Deployment-Optionen

Alle drei Modellvarianten können sowohl lokal als auch in der Cloud genutzt werden – wobei die Anforderungen je nach Modell stark variieren. Hier ein praktischer Überblick für verschiedene Einsatzszenarien:

Lokale Installation

Das Large-Modell lässt sich dank optimierter Quantisierung auch auf Consumer-GPUs mit 8GB VRAM betreiben. Ähnlich wie bei Flux, das ebenfalls für Consumer-Hardware optimiert wurde, erreicht man dies durch FP8- oder INT4-Quantisierung. Die Bildqualität bleibt dabei erstaunlich gut erhalten. Für optimale Performance empfiehlt sich dennoch eine GPU mit 12GB oder mehr VRAM.

Cloud & API

Für Teams, die maximale Flexibilität ohne eigene Hardware-Investitionen suchen, stehen verschiedene Cloud-Lösungen zur Verfügung. Die API-Integration ermöglicht dabei eine nahtlose Einbindung in bestehende Workflows.

Besonderheiten im Vergleich

Anders als bei der Konkurrenz von Midjourney oder DALL-E 3 behält man bei lokaler Installation die volle Kontrolle über seine Daten. Ein wichtiger Aspekt für Unternehmen, die sensible Markeninformationen verarbeiten. Im direkten Vergleich mit Flux zeigt sich SD 3.5 dabei effizienter im Ressourcenverbrauch und laut ersten Tests auch flexibler im Training.

Wo kann man Stable Diffusion 3.5 testen?

Lokale Installation

Die Modellgewichte sind über Hugging Face verfügbar und lassen sich in beliebige Stable Diffusion Frontends wie ComfyUI integrieren.

Dank der optimierten Quantisierung läuft selbst das Large-Modell auf Consumer-GPUs mit mindestens 8GB VRAM. Für die Installation empfehlen wir ComfyUI, da es aktuell die beste Integration der neuen Modelle bietet.

Hier gehts zum ComfyUi Workflow-Download: .json herunterladen

Quelle: ComfyUi WIKI Manual

| Model | Downloadlink | Installationspfad |

| Stable Diffusion 3.5 Large | Download Link | models/checkpoint |

| Stable Diffusion 3.5 Large Turbo | Download Link | models/checkpoint |

Online-Nutzung

Wer nicht lokal installieren möchte, hat mehrere Möglichkeiten für den Online-Zugriff:

- Über die offizielle Stability AI API

- Auf der Plattform Replicate

- Bei DeepInfra

- Über verschiedene Web-Interfaces wie stablediffusion3.net

Die meisten dieser Plattformen bieten ein kostenloses Kontingent zum Testen. Für die professionelle Nutzung empfiehlt sich jedoch der Zugriff über die offizielle API oder eine lokale Installation. Dieser Artikel wird laufend aktualisiert, sobald neue Community-Modelle auf Basis von SD 3.5 verfügbar sind.

Fachliche Einordnung

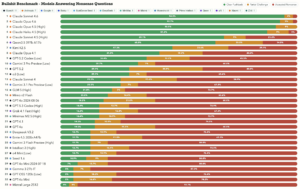

Nach der enttäuschenden Performance von SD3 Medium hat Stability AI mit Version 3.5 nachgebessert – wenn auch nicht in allen Bereichen überzeugend. Die grundlegenden Schwächen bei der Darstellung menschlicher Anatomie bestehen weiterhin, und auch in Sachen Bildqualität erreicht das Basis-Modell noch nicht das Niveau von FLUX.1.

Stärken und Schwächen

Im direkten Vergleich zeigt sich: Während FLUX.1 bei fotorealistischen Bildern klar die Nase vorn hat, kann SD 3.5 Large besonders bei künstlerischen Stilen punkten. Die Prompt-Genauigkeit wurde zwar verbessert, erreicht aber noch nicht die Präzision von Flux.

Potenzial durch Community

Die wahre Stärke von SD 3.5 liegt in seiner Offenheit. Anders als bei FLUX lassen sich die Modelle hervorragend trainieren und optimieren – ähnlich wie wir es von SDXL kennen. Das bedeutet: In den kommenden Monaten werden wir voraussichtlich zahlreiche optimierte Full-Parameter-Finetunings sehen, vergleichbar mit erfolgreichen Modellen wie Dreamshaper, Juggernaut oder Pony.

Positionierung im Markt

SD 3.5 positioniert sich klar als Open-Source-Alternative zum neuen Platzhirsch FLUX. Zwar hinkt das Basis-Modell in puncto Bildqualität und Anatomie-Verständnis noch hinterher, doch die offene Lizenzierung und die aktive Community könnten diesen Rückstand schnell aufholen. Die Kombination aus solider Grundlage und Open-Source-Philosophie macht SD 3.5 besonders für Teams interessant, die Wert auf Anpassbarkeit und Community-Entwicklung legen.

Fazit & Ausblick

Stable Diffusion 3.5 ist ein zweischneidiges Schwert: Einerseits erfüllt das Basis-Modell nicht alle hochgesteckten Erwartungen, andererseits bietet es eine vielversprechende Grundlage für die Community-Entwicklung.

Für die Praxis bedeutet das:

Marketing-Teams sollten SD 3.5 zunächst als ergänzendes Tool betrachten. Wer fotorealistische Produktvisualisierungen oder anatomisch perfekte Menschen benötigt, ist aktuell mit FLUX.1 besser bedient. Die Stärke liegt eher bei künstlerischen Projekten und in der Flexibilität der Entwicklungsumgebung.

Der wahre Wert steckt im Ökosystem

Die offene Architektur und die Community-freundliche Lizenzierung werden in den nächsten Monaten für spannende Entwicklungen sorgen. Wie schon bei SDXL werden optimierte Finetunings die aktuellen Schwächen des Basis-Modells ausgleichen. Für Agenturen und Marketing-Teams lohnt es sich daher, die Community-Entwicklungen im Auge zu behalten.Empfehlung

Wer bereits mit Stable Diffusion arbeitet, sollte auf jeden Fall ein Upgrade auf Version 3.5 in Betracht ziehen. Die verbesserte Prompt-Verarbeitung und die verschiedenen Modellvarianten bieten mehr Flexibilität im Workflow. Gleichzeitig empfiehlt sich ein paralleler Blick auf FLUX.1 – besonders für professionelle Anwendungsfälle, die maximale Bildqualität erfordern.

Die kommenden Monate werden zeigen, ob die Community das Potenzial von SD 3.5 ausschöpfen und damit wieder zu einem ernsthaften Konkurrenten im Bereich der Bildgenerierung machen kann.

Du willst lernen wie du SD3, Flux, Midjourney für dein Marketing nutzen kannst?

Du willst mehr über den strategischen Einsatz von Bild-KI in deinem Marketing erfahren? In unserem KI Marketing Bootcamp zeigen wir dir, wie du Stable Diffusion, FLUX und Co. effizient in deinen Workflow integrierst. Wir vermitteln nicht nur die technischen Skills, sondern auch das strategische Know-how, um die Stärken jedes Modells optimal zu nutzen.

Im Bootcamp lernst du u.a.:

- Welches KI-Modell sich für welche Aufgabe am besten eignet

- Wie du effiziente Prompts für verschiedene Bildstile entwickelst

- Praktische Workflows für Marketing und Design

- Tipps für die Integration in deine bestehenden Prozesse

Sichere dir jetzt deinen Platz im nächsten Bootcamp und werde zum KI-Marketing-Experten. Alle Infos und Termine findest du hier: